În această eră, Transformers sunt cele mai puternice modele care au oferit cele mai bune rezultate în mai multe operațiuni NLP (Natural Language Processing). Inițial, a fost utilizat pentru sarcini de modelare a limbii, inclusiv generarea de text, precum și clasificare, traducere automată și multe altele. Dar acum, este folosit și pentru recunoașterea obiectelor, clasificarea imaginilor și multiple alte sarcini de viziune computerizată.

În acest tutorial, vom oferi procedura de realizare a clasificării textului folosind Transformers.

Cum se efectuează clasificarea textului folosind transformatoare?

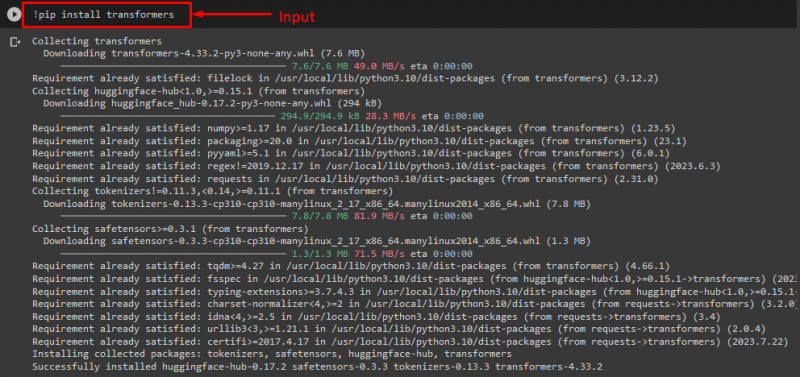

Pentru a efectua clasificarea textului folosind Transformers, în primul rând, instalați „ transformatoare ” bibliotecă prin executarea comenzii furnizate:

! pip instalare transformatoare

După cum puteți vedea, biblioteca specificată a fost instalată cu succes:

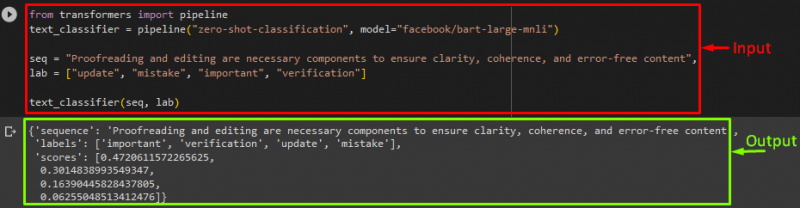

Apoi, importați „ conductă ' de la ' transformatoare ” biblioteca:

din conducta de import transformatoare

Aici ' conductă ” va include sarcina NLP pe care trebuie să o îndeplinim și modelul de transformator dorit pentru această operație împreună cu tokenizer.

Notă: Tokenizer-ul este utilizat pentru a efectua procesarea textului care urmează să fie furnizat de intrarea modelului prin separarea textului în jetoane.

După aceea, utilizați „ conductă() ” și transmiteți-i „ clasificare zero-shot ” ca argument. Apoi, treceți un alt parametru, care este modelul nostru. Folosim Facebook-ul „ BART ” model de transformator. Aici, nu folosim tokenizer-ul deoarece poate fi dedus automat de modelul specificat:

text_classifier = conductă ( 'clasificare zero-shot' , model = „facebook/bart-large-mnli” )

Acum, declarați „ secv ” variabilă care deține textul nostru de intrare care trebuie clasificat. Apoi, oferim categoriile în care dorim să clasificăm textul și să le salvăm în „ laborator ” care este cunoscut sub numele de etichete:

laborator = [ 'Actualizați' , 'greşeală' , 'important' , 'verificare' ]

În cele din urmă, rulați conducta împreună cu intrarea:

După executarea conductei, după cum puteți vedea, modelul a prezis ca secvența noastră furnizată să fie clasificată:

Informații suplimentare: Dacă doriți să accelerați performanța modelului, trebuie să utilizați GPU-ul. Dacă da, atunci, în acest scop, puteți specifica un argument de dispozitiv pentru conductă și îl puteți seta la „ 0 ” pentru a utiliza GPU.

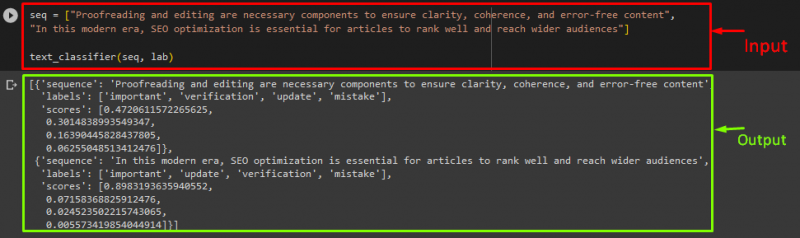

Dacă doriți să clasificați textul pe mai multe instrucțiuni de secvență/text de intrare, atunci le puteți adăuga la o listă și le puteți transmite ca intrare în conducte. În acest scop, consultați fragmentul de cod:

secv = [ „Corectarea și editarea sunt componente necesare pentru a asigura claritatea, coerența și conținutul fără erori” ,„În această eră modernă, optimizarea SEO este esențială pentru ca articolele să se clasifice bine și să ajungă la un public mai larg” ]

clasificator_text ( secv , laborator )

Ieșire

Asta este! Am compilat cel mai simplu mod de a realiza clasificarea textului folosind Transformers.

Concluzie

Transformatoarele sunt folosite pentru a efectua sarcini de modelare a limbajului, cum ar fi generarea de text, clasificarea textului și traducerea automată, precum și sarcini de viziune computerizată, inclusiv recunoașterea obiectelor și clasificarea imaginilor. În acest tutorial, am ilustrat procesul de realizare a clasificării textului folosind Transformers.