Schiță rapidă

Această postare va demonstra următoarele:

- Cum să accesați pașii intermediari ai unui agent în LangChain

- Instalarea cadrelor

- Setarea mediului OpenAI

- Import de biblioteci

- Construire LLM și agent

- Folosind Agentul

- Metoda 1: Tip de returnare implicit pentru a accesa pașii intermediari

- Metoda 2: Utilizarea „dumps” pentru a accesa pașii intermediari

- Concluzie

Cum să accesați pașii intermediari ai unui agent în LangChain?

Pentru a construi agentul în LangChain, utilizatorul trebuie să își configureze instrumentele și structura șablonului pentru a obține numărul de pași implicați în model. Agentul este responsabil pentru automatizarea pașilor intermediari, cum ar fi gândurile, acțiunile, observațiile etc. Pentru a afla cum să accesați pașii intermediari ai unui agent în LangChain, pur și simplu urmați pașii enumerați:

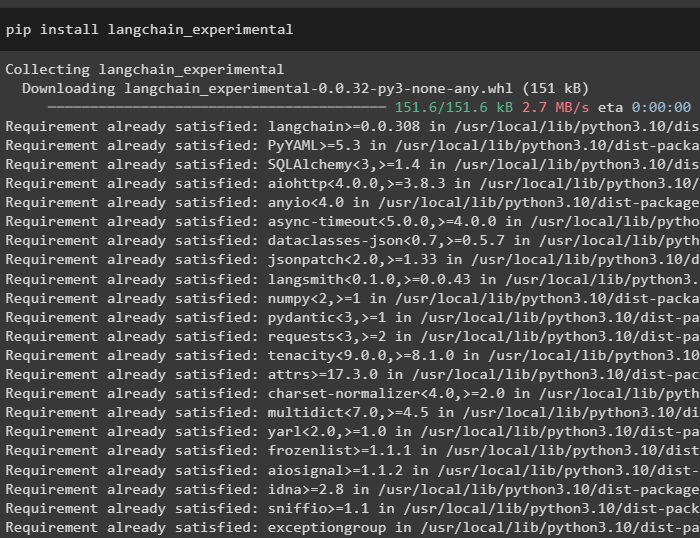

Pasul 1: Instalarea cadrelor

Mai întâi de toate, instalați pur și simplu dependențele LangChain executând următorul cod în Python Notebook:

pip install langchain_experimental

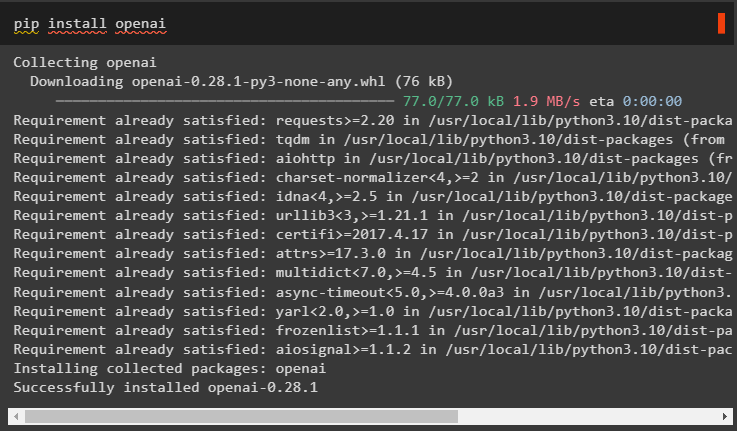

Instalați modulul OpenAI pentru a obține dependențele acestuia folosind pip comandă și folosește-le pentru a construi modelul de limbaj:

pip install openai

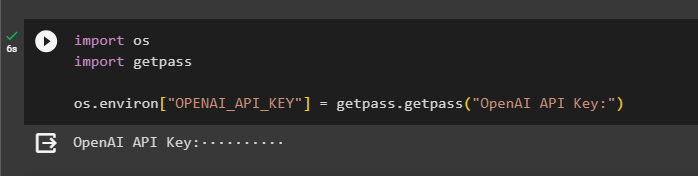

Pasul 2: Setarea mediului OpenAI

Odată ce modulele sunt instalate, configurați Mediul OpenAI folosind cheia API generată din contul său:

import tu

import getpass

tu. aproximativ [ „OPENAI_API_KEY” ] = getpass. getpass ( „Cheie API OpenAI:” )

Pasul 3: Importarea bibliotecilor

Acum că avem dependențele instalate, folosiți-le pentru a importa biblioteci din LangChain:

din langchain. agenţi import load_toolsdin langchain. agenţi import initialize_agent

din langchain. agenţi import AgentType

din langchain. llms import OpenAI

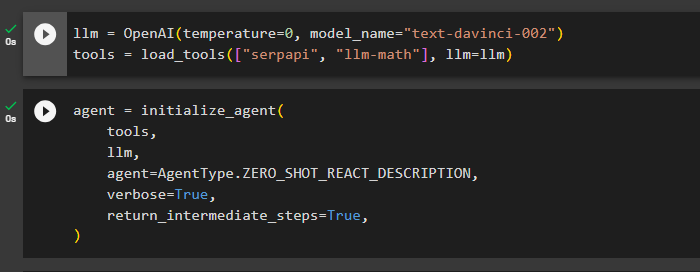

Pasul 4: Construirea LLM și agent

Odată ce bibliotecile sunt importate, este timpul să le folosiți pentru construirea modelului de limbaj și a instrumentelor pentru agent. Definiți variabila llm și atribuiți-o cu metoda OpenAI() care conține argumentele temperatură și model_name. „ unelte ” variabila conține metoda load_tools() cu instrumentele SerpAPi și llm-math și modelul de limbaj în argumentul său:

llm = OpenAI ( temperatura = 0 , numele modelului = „text-davinci-002” )unelte = load_tools ( [ 'serpapi' , 'llm-matematica' ] , llm = llm )

Odată ce modelul de limbă și instrumentele sunt configurate, pur și simplu proiectați agentul pentru a efectua pașii intermediari folosind instrumentele din modelul de limbă:

agent = initialize_agent (unelte ,

llm ,

agent = AgentType. ZERO_SHOT_REACT_DESCRIPTION ,

verboroasă = Adevărat ,

întoarcere_pași_intermediari = Adevărat ,

)

Pasul 5: Utilizarea agentului

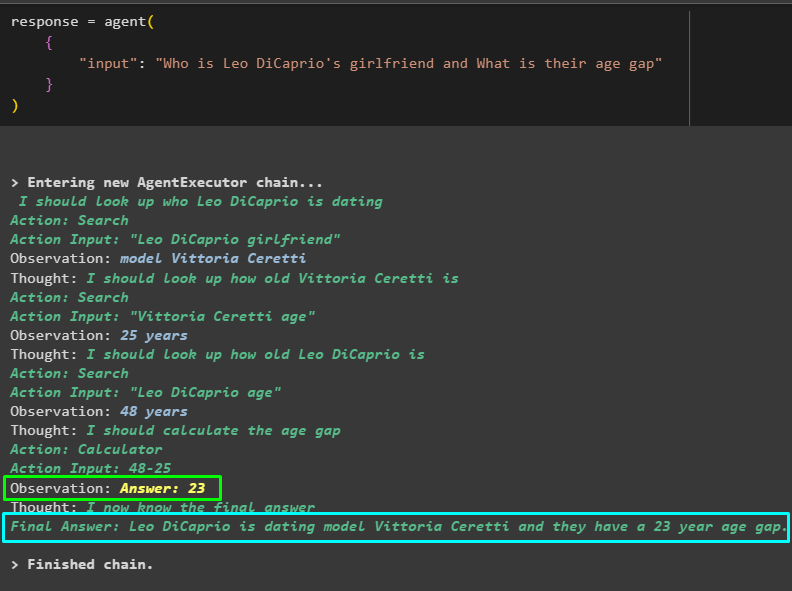

Acum, puneți agentul la încercare punând o întrebare în introducerea metodei agent() și executând-o:

raspuns = agent ({

'intrare' : „Cine este iubita lui Leo DiCaprio și care este diferența lor de vârstă”

}

)

Modelul a lucrat eficient pentru a obține numele iubitei lui Leo DiCaprio, vârsta ei, vârsta lui Leo DiCaprio și diferența dintre ele. Următoarea captură de ecran afișează câteva întrebări și răspunsuri căutate de agent pentru a ajunge la răspunsul final:

Captura de ecran de mai sus nu afișează funcționarea agentului și modul în care ajunge la acea etapă pentru a găsi toate răspunsurile. Să trecem la următoarea secțiune pentru a găsi pașii:

Metoda 1: Tip de returnare implicit pentru a accesa pașii intermediari

Prima metodă de a accesa pasul intermediar este utilizarea tipului de returnare implicit oferit de LangChain folosind următorul cod:

imprimare ( raspuns [ „pași_intermediari” ] )Următorul GIF afișează pașii intermediari într-o singură linie, ceea ce nu este destul de bun când vine vorba de aspectul lizibilității:

Metoda 2: Utilizarea „dumps” pentru a accesa pașii intermediari

Următoarea metodă explică o altă modalitate de a obține pașii intermediari folosind biblioteca de descărcare din cadrul LangChain. Utilizați metoda dumps() cu argumentul drăguț pentru a face rezultatul mai structurat și mai ușor de citit:

din langchain. sarcină . haldă import haldeleimprimare ( haldele ( raspuns [ „pași_intermediari” ] , frumos = Adevărat ) )

Acum, avem rezultatul într-o formă mai structurată, care este ușor de citit de către utilizator. De asemenea, este împărțit în mai multe secțiuni pentru a avea mai mult sens și fiecare secțiune conține pașii pentru a găsi răspunsuri la întrebări:

Este vorba despre accesarea pașilor intermediari ai unui agent în LangChain.

Concluzie

Pentru a accesa pașii intermediari ai unui agent în LangChain, instalați modulele pentru a importa biblioteci pentru construirea modelelor de limbaj. După aceea, configurați instrumente pentru a inițializa agentul folosind instrumentele, llm și tipul de agent care poate răspunde la întrebări. Odată ce agentul este configurat, testați-l pentru a obține răspunsurile și apoi utilizați biblioteca Tip implicit sau descarcă pentru a accesa pașii intermediari. Acest ghid a elaborat procesul de accesare a pașilor intermediari ai unui agent în LangChain.