Acest post ilustrează metoda de utilizare a funcțiilor și claselor parserului de ieșire prin cadrul LangChain.

Cum se utilizează analizatorul de ieșire prin LangChain?

Analizatorii de ieșire sunt ieșirile și clasele care pot ajuta la obținerea rezultatului structurat din model. Pentru a învăța procesul de utilizare a parserilor de ieșire în LangChain, parcurgeți pur și simplu pașii enumerați:

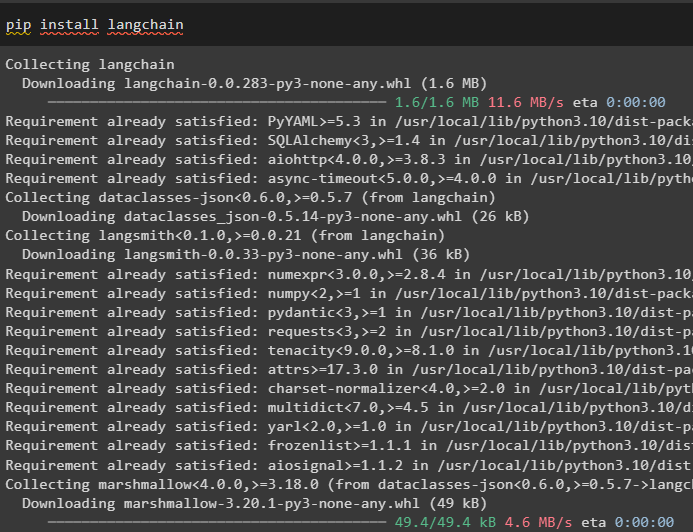

Pasul 1: Instalați module

În primul rând, începeți procesul de utilizare a parserilor de ieșire instalând modulul LangChain cu dependențele sale pentru a parcurge procesul:

pip instalare langchain

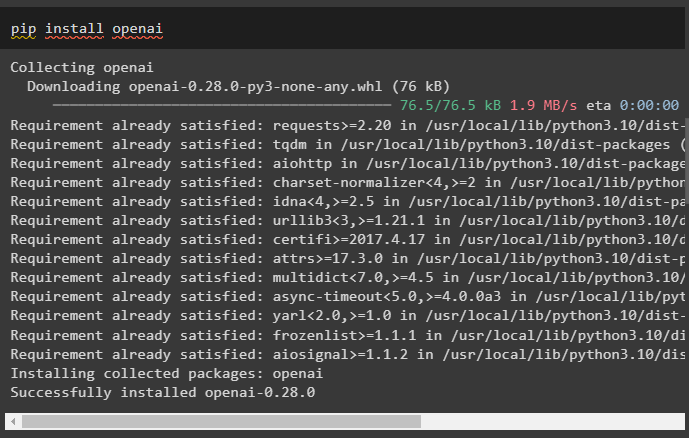

După aceea, instalați modulul OpenAI pentru a-și folosi bibliotecile precum OpenAI și ChatOpenAI:

pip instalare openai

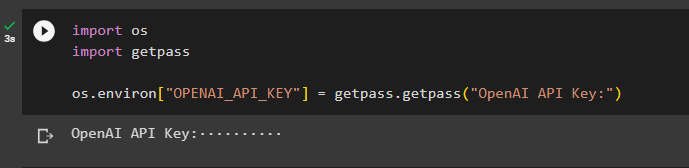

Acum, configurați mediu pentru OpenAI folosind cheia API din contul OpenAI:

importă-ne

import getpass

os.mediu [ „OPENAI_API_KEY” ] = getpass.getpass ( „Cheie API OpenAI:” )

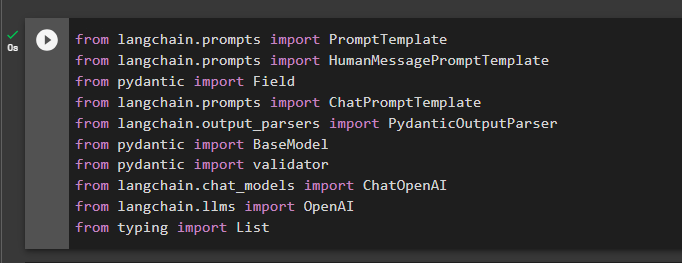

Pasul 2: importați biblioteci

Următorul pas este să importați biblioteci din LangChain pentru a utiliza analizatorii de ieșire în cadru:

din langchain.prompts import HumanMessagePromptTemplate

din câmpul de import pidantic

din langchain.prompts import ChatPromptTemplate

din langchain.output_parsers import PydanticOutputParser

din pydantic import BaseModel

de la validatorul de import pydantic

din langchain.chat_models import ChatOpenAI

din langchain.llms import OpenAI

din tastarea import List

Pasul 3: Construirea structurii datelor

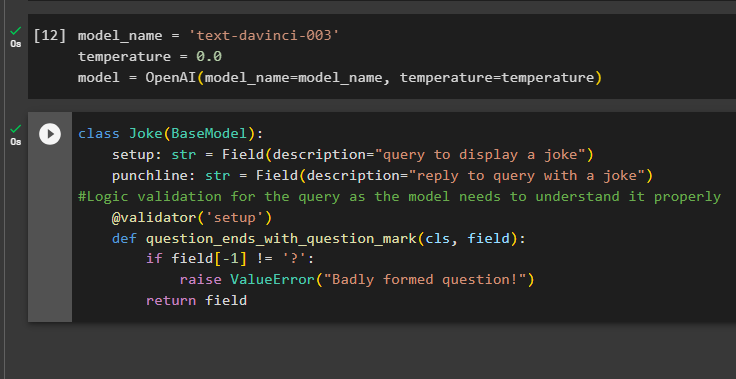

Construirea structurii ieșirii este aplicația vitală a analizatorilor de ieșire în modelele de limbă mari. Înainte de a ajunge la structura de date a modelelor, este necesar să definim numele modelului pe care îl folosim pentru a obține rezultatul structurat de la analizatorii de ieșire:

temperatura = 0,0

model = OpenAI ( numele modelului =nume_model, temperatura =temperatura )

Acum, utilizați clasa Joke care conține BaseModel pentru a configura structura ieșirii pentru a obține gluma din model. După aceea, utilizatorul poate adăuga cu ușurință o logică de validare personalizată cu clasa pydantic care îi poate cere utilizatorului să pună o interogare/prompt mai bine formată:

clasă Glumă ( Model de bază ) :setup: str = Câmp ( Descriere = 'interogare pentru a afișa o glumă' )

punchline: str = Câmp ( Descriere = „răspunde la interogare cu o glumă” )

#Validare logică pentru interogare, deoarece modelul trebuie să o înțeleagă corect

@ validator ( 'înființat' )

def question_ends_with_question_mark ( cls, câmp ) :

dacă camp [ - 1 ] ! = '?' :

ridicați ValueError ( — Întrebare prost formată! )

întoarcere camp

Pasul 4: Setarea șablonului prompt

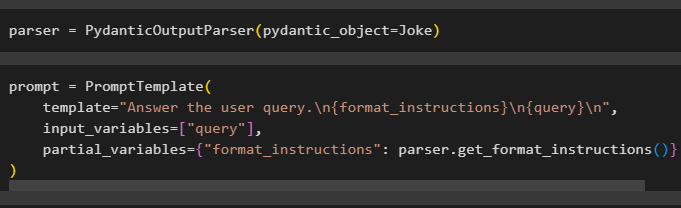

Configurați variabila parser care conține metoda PydanticOutputParser() care conține parametrii acesteia:

După configurarea parserului, definiți pur și simplu variabila prompt folosind metoda PromptTemplate() cu structura interogării/prompt-ului:

prompt = PromptTemplate (șablon = „Răspunde la întrebarea utilizatorului. \n {format_instructions} \n {interogare} \n ' ,

variabile_de intrare = [ 'interogare' ] ,

variabile_parțiale = { 'format_instructions' : parser.get_format_instructions ( ) }

)

Pasul 5: Testați analizatorul de ieșire

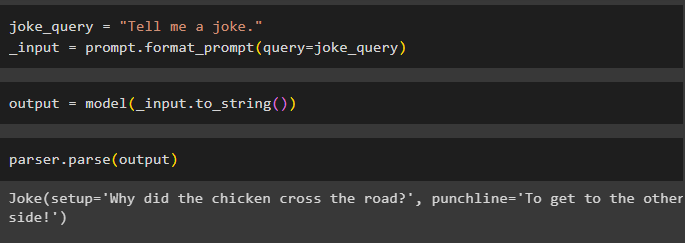

După configurarea tuturor cerințelor, creați o variabilă care este atribuită folosind o interogare și apoi apelați metoda format_prompt():

_input = prompt.format_prompt ( interogare =joke_query )

Acum, apelați funcția model() pentru a defini variabila de ieșire:

output = model ( _input.to_string ( ) )Finalizați procesul de testare apelând metoda parser() cu variabila de ieșire ca parametru:

parser.parse ( ieșire )

Acesta este totul despre procesul de utilizare a parserului de ieșire în LangChain.

Concluzie

Pentru a utiliza analizatorul de ieșire în LangChain, instalați modulele și configurați mediul OpenAI folosind cheia API. După aceea, definiți modelul și apoi configurați structura de date a ieșirii cu validarea logică a interogării furnizate de utilizator. Odată ce structura datelor este configurată, pur și simplu setați șablonul prompt și apoi testați analizatorul de ieșire pentru a obține rezultatul din model. Acest ghid a ilustrat procesul de utilizare a parserului de ieșire în cadrul LangChain.