Acest ghid va ilustra procesul de rulare a LLMChains în LangChain.

Cum să rulați LLMChains în LangChain?

LangChain oferă caracteristicile sau dependențele pentru construirea LLMChains folosind LLM-uri/Chatbot-uri și șabloane de prompt. Pentru a învăța procesul de construire și rulare a LLMChains în LangChain, pur și simplu urmați următorul ghid în pas:

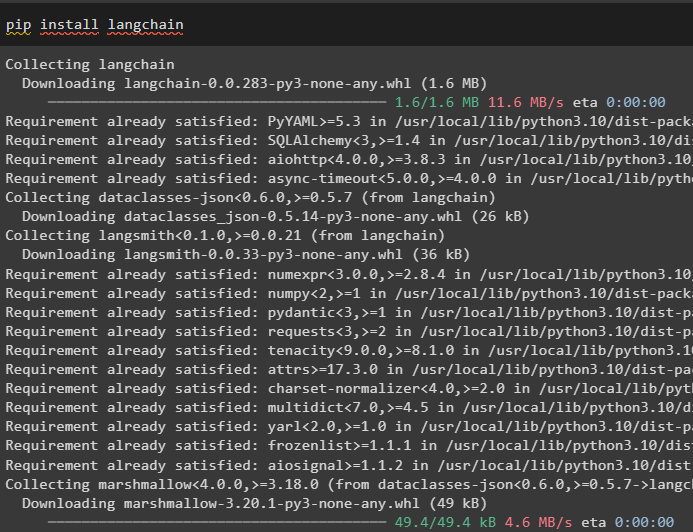

Pasul 1: Instalați pachetele

Mai întâi, începeți procesul instalând modulul LangChain pentru a obține dependențele sale pentru construirea și rularea LLMChains:

pip install langchain

Instalați cadrul OpenAI folosind comanda pip pentru a determina bibliotecile să utilizeze funcția OpenAI() pentru construirea de LLM-uri:

pip install openai

După instalarea modulelor, pur și simplu configura mediul variabile folosind cheia API din contul OpenAI:

import tu

import getpass

tu . aproximativ [ „OPENAI_API_KEY” ] = getpass . getpass ( „Cheie API OpenAI:” )

Pasul 2: importați biblioteci

Odată ce configurarea este completă și toate pachetele necesare sunt instalate, importați bibliotecile necesare pentru construirea șablonului prompt. După aceea, pur și simplu construiți LLM folosind metoda OpenAI() și configurați LLMChain folosind LLM-urile și șablonul prompt:

din langchain import PromptTemplatedin langchain import OpenAI

din langchain import LLMChain

prompt_template = „Dă-mi un titlu bun pentru afaceri care fac {produs}?”

llm = OpenAI ( temperatura = 0 )

llm_chain = LLMChain (

llm = llm ,

prompt = PromptTemplate. din_şablon ( prompt_template )

)

llm_chain ( „haine colorate” )

Pasul 3: Lanțuri de rulare

Obțineți lista de intrare care conține diverse produse produse de companie și rulați lanțul pentru a afișa lista pe ecran:

lista_intrarilor = [{ 'produs' : 'șosete' } ,

{ 'produs' : 'calculator' } ,

{ 'produs' : 'pantofi' }

]

llm_chain. aplica ( lista_intrarilor )

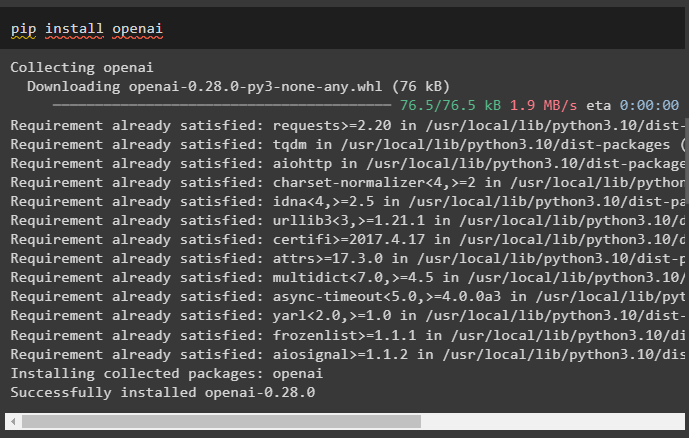

Rulați metoda generate() folosind lista_intrarilor cu LLMChains pentru a obține rezultatul legat de conversația generată de model:

llm_chain. Genera ( lista_intrarilor )

Pasul 4: Utilizarea intrării unice

Adăugați un alt produs pentru a rula LLMChains utilizând doar o singură intrare și apoi preziceți LLMChain pentru a genera rezultatul:

llm_chain. prezice ( produs = 'șosete colorate' )Pasul 5: Utilizarea intrărilor multiple

Acum, construiți șablonul pentru utilizarea mai multor intrări pentru a furniza comanda modelului înainte de a rula lanțul:

șablon = '''Spune-mi o glumă cu {adjectiv} despre {subiect}.'''prompt = PromptTemplate ( șablon = șablon , variabile_de intrare = [ 'adjectiv' , 'subiect' ] )

llm_chain = LLMChain ( prompt = prompt , llm = OpenAI ( temperatura = 0 ) )

llm_chain. prezice ( adjectiv = 'trist' , subiect = 'rațe' )

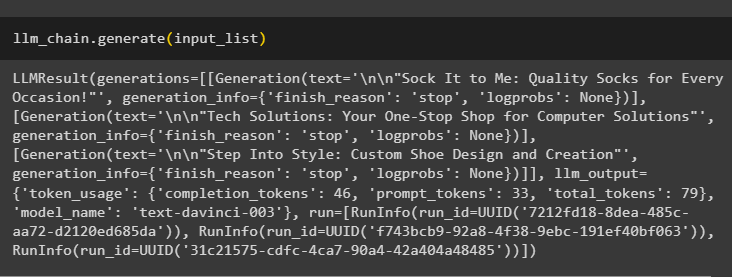

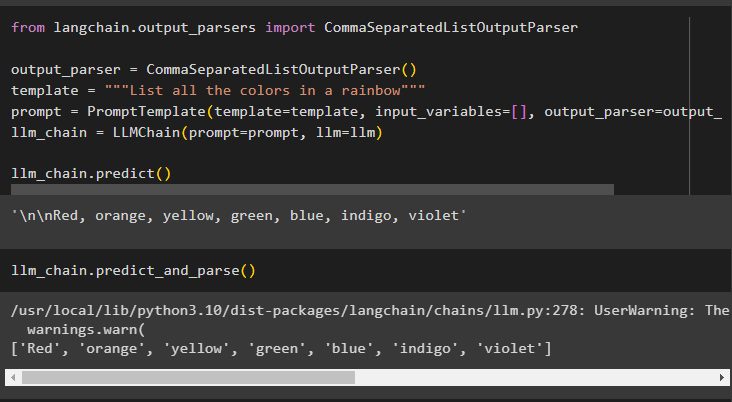

Pasul 6: Folosind Output Parser

Acest pas folosește metoda parserului de ieșire pentru a rula LLMChain pentru a obține rezultatul pe baza promptului:

din langchain. analizoare_ieșire import CommaSeparatedListOutputParseranalizator_ieșire = CommaSeparatedListOutputParser ( )

șablon = '''Enumeră toate culorile dintr-un curcubeu'''

prompt = PromptTemplate ( șablon = șablon , variabile_de intrare = [ ] , analizator_ieșire = analizator_ieșire )

llm_chain = LLMChain ( prompt = prompt , llm = llm )

llm_chain. prezice ( )

Folosind metoda parse() pentru a obține rezultatul va genera o listă separată prin virgulă cu toate culorile din curcubeu:

llm_chain. prezice_și_parse ( )

Pasul 7: Inițializarea din șiruri

Acest pas explică procesul de utilizare a unui șir ca prompt pentru a rula LLMChain folosind modelul și șablonul LLM:

șablon = '''Spune-mi o glumă cu {adjectiv} despre {subiect}'''llm_chain = LLMChain. from_string ( llm = llm , șablon = șablon )

Furnizați valorile variabilelor în promptul șir pentru a obține rezultatul din model rulând LLMChain:

llm_chain. prezice ( adjectiv = 'trist' , subiect = 'rațe' )Acesta este totul despre rularea LLMChains folosind cadrul LangChain.

Concluzie

Pentru a construi și a rula LLMChains în LangChain, instalați cerințele prealabile precum pachetele și configurați mediul folosind cheia API a OpenAI. După aceea, importați bibliotecile necesare pentru configurarea șablonului și modelului prompt pentru rularea LLMChain folosind dependențele LangChain. Utilizatorul poate folosi analizatori de ieșire și comenzi șir pentru a rula LLMChains, așa cum este demonstrat în ghid. Acest ghid a elaborat procesul complet de rulare a LLMChains în LangChain.