În acest blog, ne vom concentra asupra modalităților în care puteți crește utilizarea GPU-ului în PyTorch.

Cum să creșteți utilizarea GPU-ului în PyTorch?

Există mai multe tehnici care pot fi folosite pentru a crește utilizarea GPU-ului și pentru a se asigura că cele mai bune resurse hardware sunt utilizate pentru procesarea modelelor complexe de învățare automată. Aceste tactici implică editarea codului și utilizarea funcțiilor PyTorch. Câteva sfaturi și trucuri importante sunt enumerate mai jos:

- Încărcarea datelor și dimensiunilor lotului

- Modele mai puțin dependente de memorie

- PyTorch Lightning

- Ajustați setările de rulare în Google Colab

- Goliți memoria cache pentru optimizare

Încărcarea datelor și dimensiunilor lotului

„ Încărcător de date ” în PyTorch este folosit pentru a defini specificațiile datelor care urmează să fie încărcate în procesor cu fiecare trecere înainte a modelului de deep learning. Un „mai mare” dimensiunea lotului ” de date va necesita mai multă putere de procesare și va crește gradul de utilizare a GPU-ului disponibil.

Sintaxa pentru alocarea unui Dataloader cu o anumită dimensiune de lot în PyTorch unei variabile personalizate este dată mai jos:

Increase_GPU_Utilization = DataLoader ( batch_size = 32 )

Modele mai puțin dependente de memorie

Fiecare arhitectură model necesită un volum diferit de „ memorie ” pentru a performa la nivelul optim. Modelele care sunt eficiente în utilizarea mai puțină memorie pe unitatea de timp sunt capabile să lucreze cu dimensiuni de lot care sunt mult mai mari decât cele ale altora.

PyTorch Lightning

PyTorch are o versiune redusă care este „ PyTorch Lightning ”. Este optimizat pentru o performanță fulgerătoare, așa cum se poate vedea din numele său. Lightning folosește GPU-uri în mod implicit și oferă o procesare mult mai rapidă pentru modelele de învățare automată. Un avantaj major al Lightning este lipsa cerințelor pentru codul standard care poate împiedica procesarea.

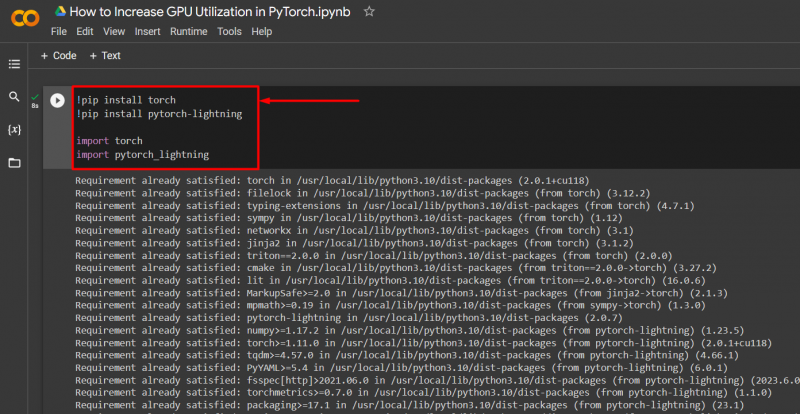

Importați bibliotecile necesare într-un proiect PyTorch cu sintaxa de mai jos:

! pip install lanternă

! pip install pytorch - fulger

import torță

import pytorch_lightning

Ajustați setările de rulare în Google Colab

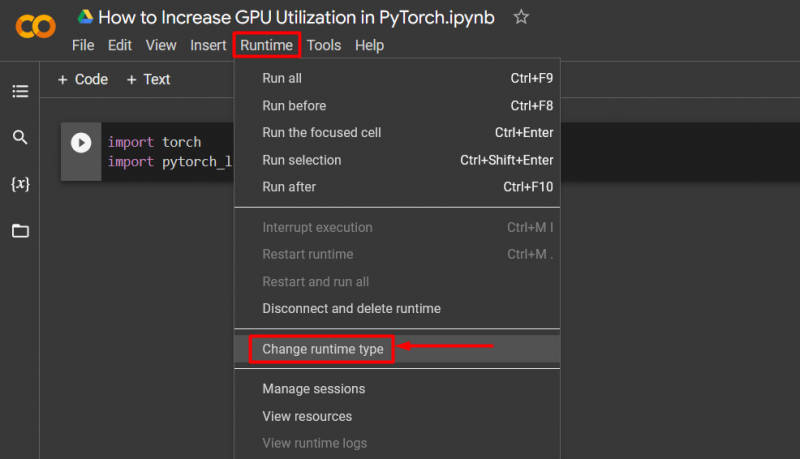

Google Colaboratory este un IDE cloud care oferă acces gratuit la GPU utilizatorilor săi pentru dezvoltarea modelelor PyTorch. Implicit, proiectele Colab rulează pe CPU, dar setările pot fi modificate.

Deschideți caietul Colab, accesați „ Timp de rulare ” din bara de meniu și derulați în jos până la „ Modificați setările de rulare ”:

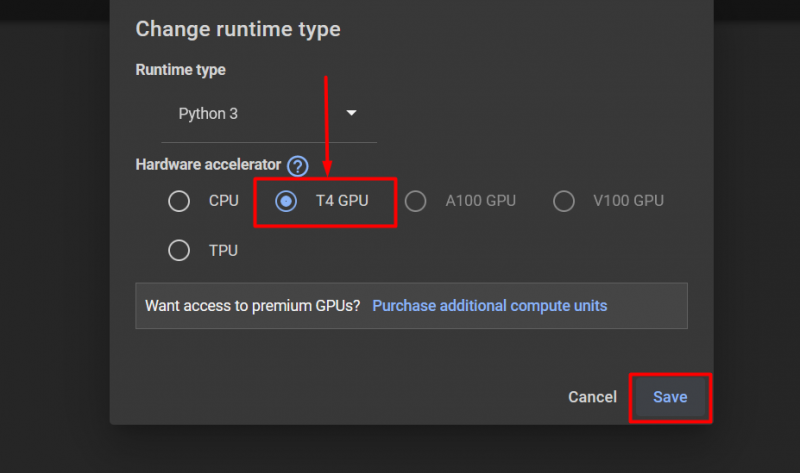

Apoi, selectați „GPU T4” opțiunea și faceți clic pe „ Salvați ” pentru a aplica modificările pentru a utiliza GPU:

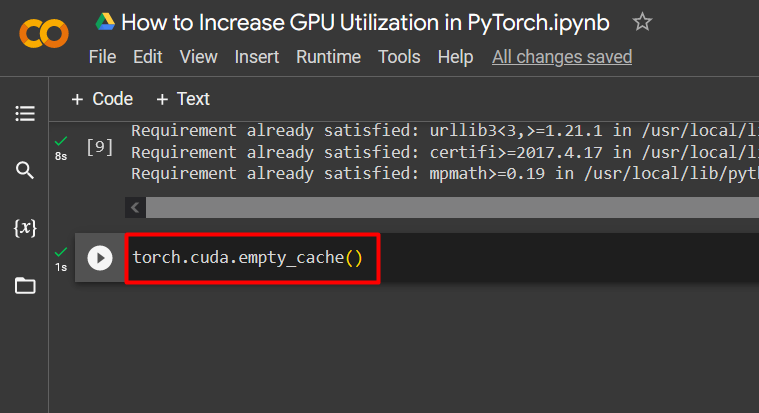

Goliți memoria cache pentru optimizare

PyTorch permite utilizatorilor săi să golească memoria cache pentru a putea elibera spațiu pentru rularea noilor procese. „ Cache ” stochează date și informații despre modelele rulate, astfel încât să poată economisi timp care va fi cheltuit în reîncărcarea acestor modele. Golirea memoriei cache oferă utilizatorilor mai mult spațiu pentru a rula modele noi.

Comanda de golire a memoriei cache a GPU este dată mai jos:

torță. diferit . empty_cache ( )

Aceste sfaturi sunt folosite pentru a optimiza rularea modelelor de învățare automată cu GPU-uri în PyTorch.

Pro-Tip

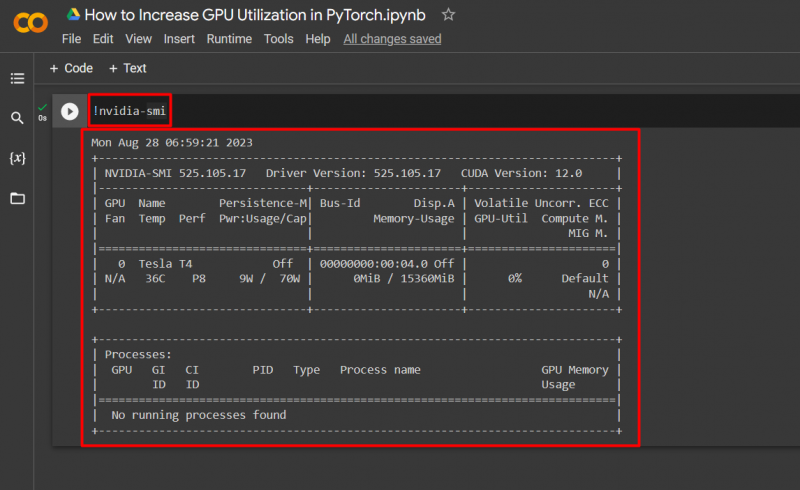

Google Colab permite utilizatorilor săi să acceseze detalii despre utilizarea GPU-ului prin „ nvidia ” pentru a obține informații despre unde sunt utilizate resursele hardware. Comanda pentru a afișa detaliile de utilizare a GPU este dată mai jos:

! nvidia - zâmbi

Succes! Tocmai am demonstrat câteva moduri de a crește utilizarea GPU-ului în PyTorch.

Concluzie

Creșteți utilizarea GPU-ului în PyTorch prin ștergerea memoriei cache, folosind PyTorch Lightning, ajustând setările de rulare, folosind modele eficiente și dimensiuni optime ale loturilor. Aceste tehnici contribuie în mare măsură la asigurarea faptului că modelele de învățare profundă funcționează cel mai bine și sunt capabile să tragă concluzii și inferențe valide din datele disponibile. Am demonstrat tehnicile de creștere a utilizării GPU-ului.