Această postare va ilustra procesul de construire a aplicațiilor LangChain folosind șablonul prompt și analizatorul de ieșire.

Cum să construiți aplicații LangChain folosind șablonul prompt și analizatorul de ieșire?

Pentru a construi aplicația LangChain folosind șablonul prompt și analizatorul de ieșire, parcurgeți pur și simplu acest ghid ușor:

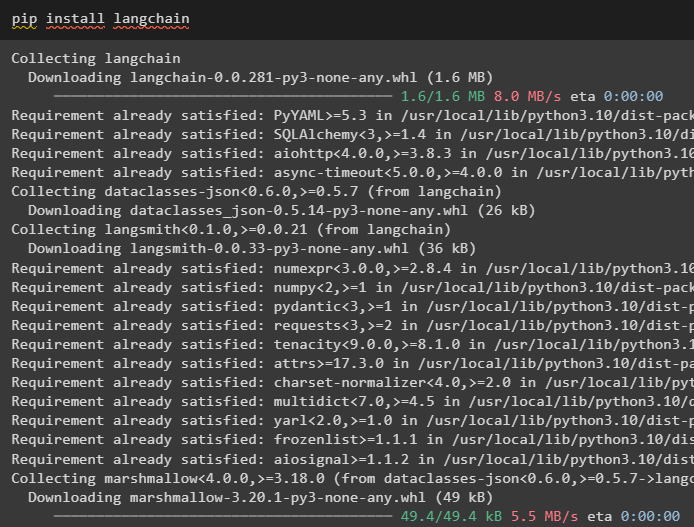

Pasul 1: Instalați LangChain

Mai întâi, începeți procesul de construire a aplicațiilor LangChain instalând cadrul LangChain utilizând „ pip ”comandă:

pip install langchain

Pasul 2: Utilizarea șablonului prompt

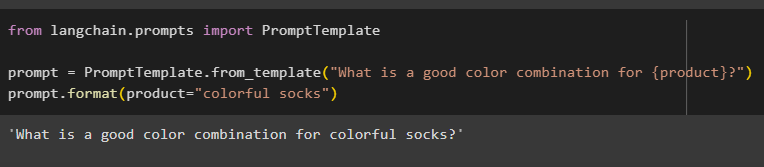

După instalarea modulelor LangChain, importați „ PromptTemplate ” pentru a construi un șablon prompt, oferind o interogare pentru ca modelul să înțeleagă întrebarea:

din langchain.prompts import PromptTemplate

prompt = PromptTemplate.from_template(„Care este o combinație bună de culori pentru {produs}?”)

prompt.format(produs='șosete colorate')

Ieșirea a combinat automat propoziția cu valoarea „ produs ' variabil:

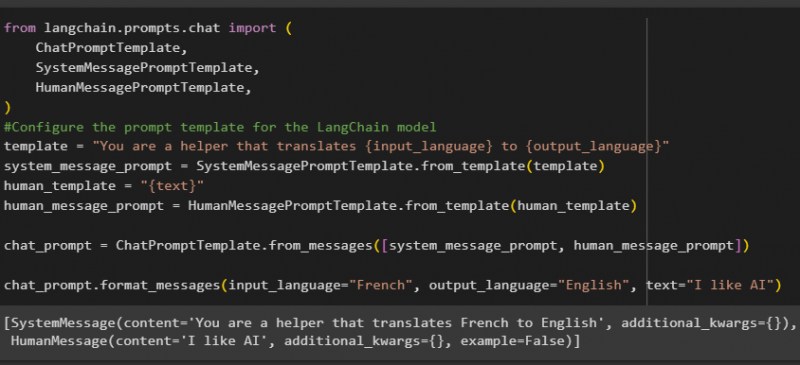

După aceea, construiți un alt șablon de prompt importând bibliotecile HumanMessagePromptTemplate, ChatPromptTemplate și SystemMessagePromptTemplate din LangChain:

din import langchain.prompts.chat (ChatPromptTemplate,

SystemMessagePromptTemplate,

HumanMessagePromptTemplate,

)

#Configurați șablonul prompt pentru modelul LangChain

template = „Sunteți un ajutor care traduce {input_language} în {output_language}”

system_message_prompt = SystemMessagePromptTemplate.from_template(șablon)

human_template = '{text}'

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_language='franceză', output_language='engleză', text='îmi place AI')

După ce ați importat toate bibliotecile necesare, construiți pur și simplu șablonul personalizat pentru interogări folosind variabila șablon:

Șabloanele de prompt sunt folosite doar pentru a seta șablonul pentru interogare/întrebare și nu răspunde cu niciun răspuns la întrebare. Cu toate acestea, funcția OutputParser() poate extrage răspunsuri, așa cum se explică în următoarea secțiune cu exemplul:

Pasul 3: Folosind Output Parser

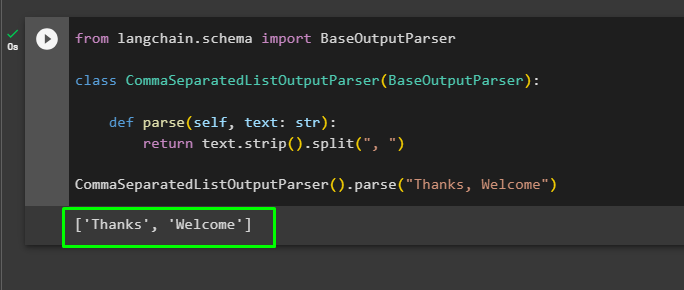

Acum, importați biblioteca BaseOutputParser din LangChain pentru a separa valorile text separate prin virgule și a returna lista în rezultat:

din langchain.schema import BaseOutputParserclasa CommaSeparatedListOutputParser(BaseOutputParser):

def parse(self, text: str):

returnează text.strip().split(', ')

CommaSeparatedListOutputParser().parse(„Mulțumesc, bine ați venit”)

Acesta este totul despre construirea aplicației LangChain folosind șablonul prompt și analizatorul de ieșire.

Concluzie

Pentru a construi o aplicație LangChain folosind șablonul prompt și analizatorul de ieșire, pur și simplu instalați LangChain și importați biblioteci din acesta. Biblioteca PromptTemplate este folosită pentru a construi structura interogării, astfel încât modelul să poată înțelege întrebarea înainte de a extrage informații folosind funcția Parser(). Funcția OutputParser() este folosită pentru a prelua răspunsuri pe baza interogărilor personalizate anterior. Acest ghid a explicat procesul de construire a aplicațiilor LangChain folosind șablonul prompt și analizatorul de ieșire.