Acest ghid va ilustra procesul de utilizare a graficului de cunoștințe de conversație în LangChain.

Cum să utilizați graficul de cunoștințe de conversație în LangChain?

The ConversațieKGMemorie biblioteca poate fi folosită pentru a recrea memoria care poate fi folosită pentru a obține contextul interacțiunii. Pentru a învăța procesul de utilizare a graficului de cunoștințe de conversație în LangChain, parcurgeți pur și simplu pașii enumerați:

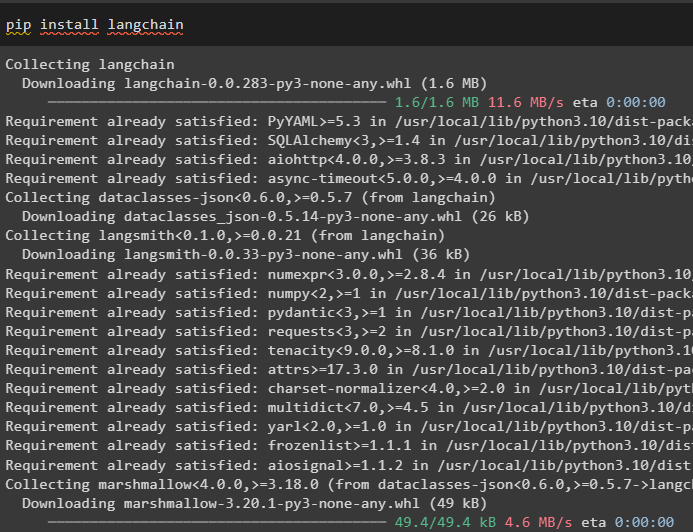

Pasul 1: Instalați module

Mai întâi, începeți procesul de utilizare a graficului de cunoștințe de conversație instalând modulul LangChain:

pip install langchain

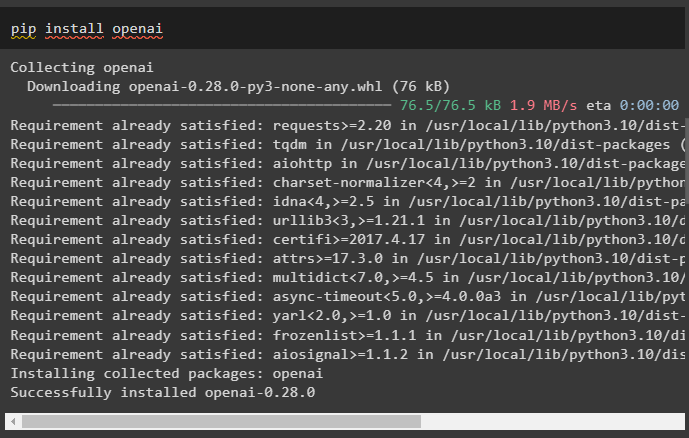

Instalați modulul OpenAI care poate fi instalat folosind comanda pip pentru a obține bibliotecile sale pentru construirea de modele de limbaj mari:

pip install openai

Acum, configura mediul folosind cheia API OpenAI care poate fi generată din contul său:

import tu

import getpass

tu . aproximativ [ „OPENAI_API_KEY” ] = getpass . getpass ( „Cheia API OpenAI:” )

Pasul 2: Utilizarea memoriei cu LLM

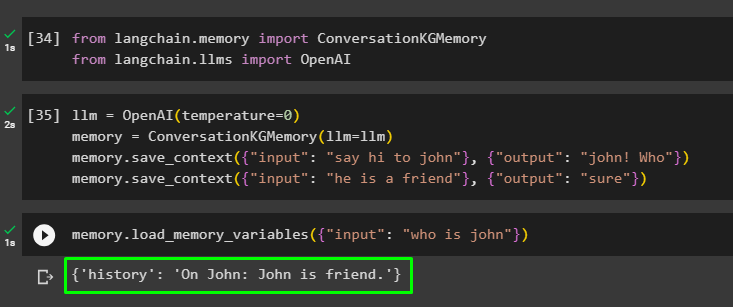

Odată ce modulele sunt instalate, începeți să utilizați memoria cu LLM importând bibliotecile necesare din modulul LangChain:

din langchain. memorie import ConversațieKGMemoriedin langchain. llms import OpenAI

Construiți LLM folosind metoda OpenAI() și configurați memoria folosind ConversațieKGMemorie () metoda. După aceea, salvați șabloanele de prompt folosind mai multe intrări cu răspunsul lor respectiv pentru a antrena modelul pe aceste date:

llm = OpenAI ( temperatura = 0 )memorie = ConversațieKGMemorie ( llm = llm )

memorie. salvare_context ( { 'intrare' : 'Saluteaza-l pe John' } , { 'ieșire' : 'John! Cine' } )

memorie. salvare_context ( { 'intrare' : 'el este un prieten' } , { 'ieșire' : 'sigur' } )

Testați memoria încărcând fișierul memorie_variabile () metoda folosind interogarea legată de datele de mai sus:

memorie. load_memory_variables ( { 'intrare' : 'cine este Ioan' } )

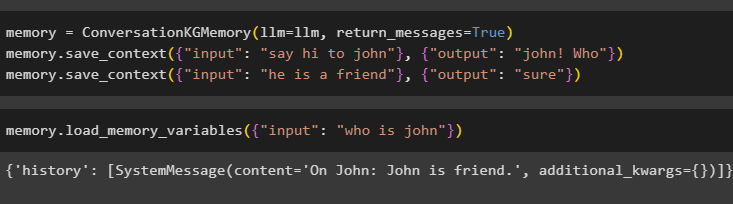

Configurați memoria folosind metoda ConversationKGMemory() cu return_messages argument pentru a obține și istoricul intrării:

memorie = ConversațieKGMemorie ( llm = llm , return_messages = Adevărat )memorie. salvare_context ( { 'intrare' : 'Saluteaza-l pe John' } , { 'ieșire' : 'John! Cine' } )

memorie. salvare_context ( { 'intrare' : 'el este un prieten' } , { 'ieșire' : 'sigur' } )

Pur și simplu testați memoria furnizând argumentului de intrare valoarea sa sub forma unei interogări:

memorie. load_memory_variables ( { 'intrare' : 'cine este Ioan' } )

Acum, testați memoria punând întrebarea care nu este menționată în datele de antrenament, iar modelul nu are idee despre răspuns:

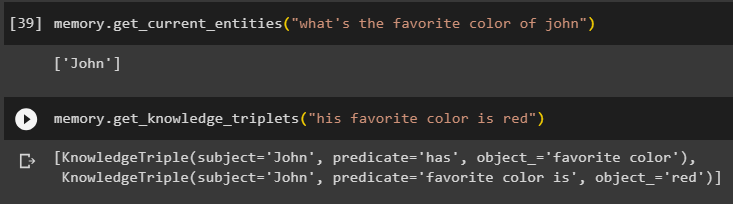

memorie. get_current_entities ( „Care este culoarea preferată a lui John” )Folosește obţine_cunoaştere_tripleţi () prin răspunsul la întrebarea solicitată anterior:

memorie. obţine_cunoaştere_tripleţi ( „culoarea lui preferată este roșu” )

Pasul 3: Utilizarea memoriei în lanț

Următorul pas folosește memoria de conversație cu lanțurile pentru a construi modelul LLM folosind metoda OpenAI(). După aceea, configurați șablonul prompt folosind structura conversației și textul va fi afișat în timp ce obțineți rezultatul de către model:

llm = OpenAI ( temperatura = 0 )din langchain. solicitări . prompt import PromptTemplate

din langchain. lanţuri import ConversationChain

șablon = '''Acesta este șablonul pentru interacțiunea dintre om și mașină

Sistemul este un model AI care poate vorbi sau extrage informații despre mai multe aspecte

Dacă nu înțelege întrebarea sau are răspunsul, pur și simplu spune așa

Sistemul extrage datele stocate în secțiunea „Specific” și nu halucinează

Specific:

{istorie}

Conversaţie:

Om: {input}

AI:'''

#Configurați șablonul sau structura pentru furnizarea de solicitări și obținerea de răspuns de la sistemul AI

prompt = PromptTemplate ( variabile_de intrare = [ 'istorie' , 'intrare' ] , șablon = șablon )

conversație_cu_kg = ConversationChain (

llm = llm , verboroasă = Adevărat , prompt = prompt , memorie = ConversațieKGMemorie ( llm = llm )

)

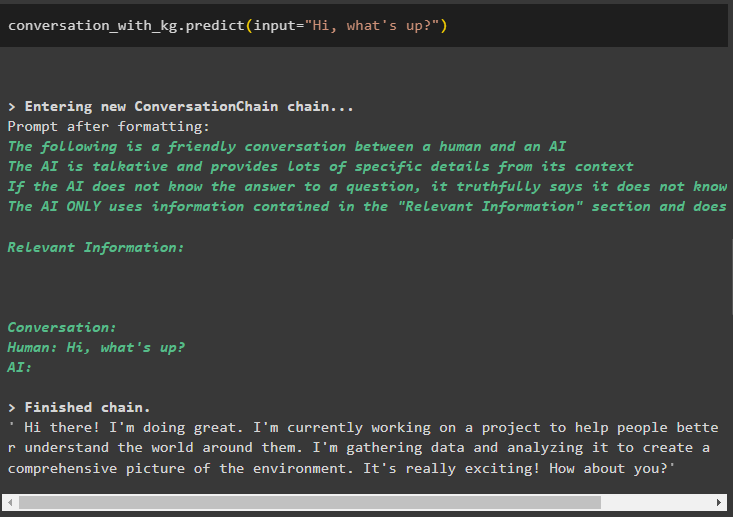

Odată ce modelul este creat, pur și simplu apelați conversație_cu_kg modelați folosind metoda predict() cu interogarea cerută de utilizator:

conversație_cu_kg. prezice ( intrare = 'Bună! Ce faci?' )

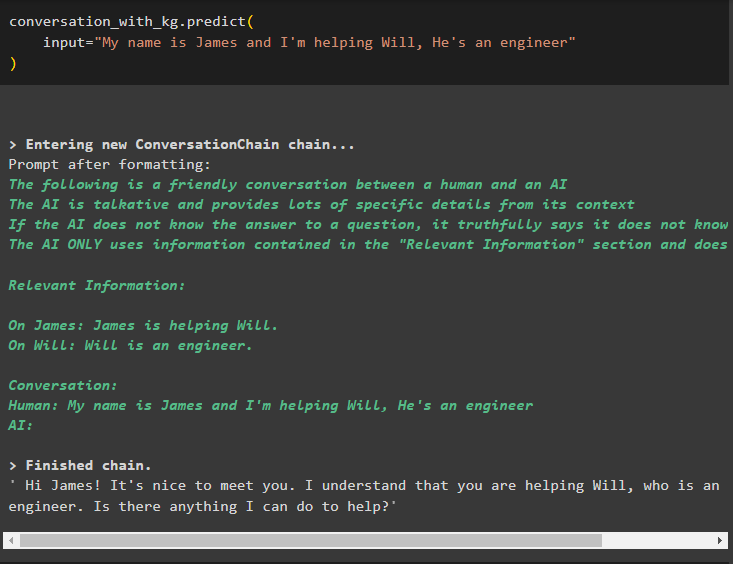

Acum, antrenați modelul folosind memoria de conversație, oferind informațiile ca argument de intrare pentru metodă:

conversație_cu_kg. prezice (intrare = „Numele meu este James și îl ajut pe Will, este inginer”

)

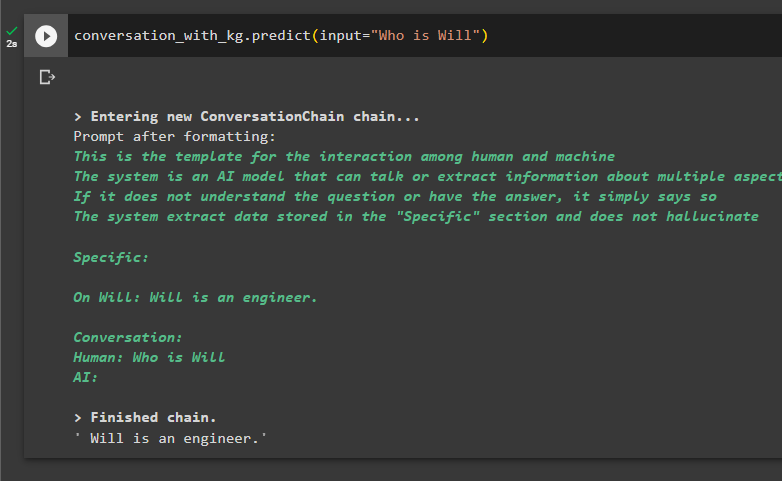

Iată momentul pentru a testa modelul solicitând interogărilor să extragă informații din date:

conversație_cu_kg. prezice ( intrare = „Cine este Will” )

Este vorba despre utilizarea graficului de cunoștințe de conversație în LangChain.

Concluzie

Pentru a utiliza graficul de cunoștințe de conversație în LangChain, instalați modulele sau cadrele pentru a importa biblioteci pentru utilizarea metodei ConversationKGMemory(). După aceea, construiți modelul folosind memoria pentru a construi lanțurile și pentru a extrage informații din datele de antrenament furnizate în configurație. Acest ghid a elaborat procesul de utilizare a graficului de cunoștințe de conversație în LangChain.